故事要從今年三月初說起。

今年三月,Google被爆料已經與美國國防部(五角大樓)達成合作,幫助後者開發應用於無人機的人工智能係統,項目代號 Project Maven。

消息一出,瞬間風起雲湧,谷歌員工表達了對此項目的強烈不滿。 有員工認為Google 在為五角大樓開放資源,助紂為虐般地幫助後者打造無人機監控技術;還有一部分人質疑Google 如此使用機器學習技術是否符合道德標準,他們認為五角大樓會將這一技術用於殺傷 性武器,進而帶來技術樂觀派們從未想要造成的傷害。

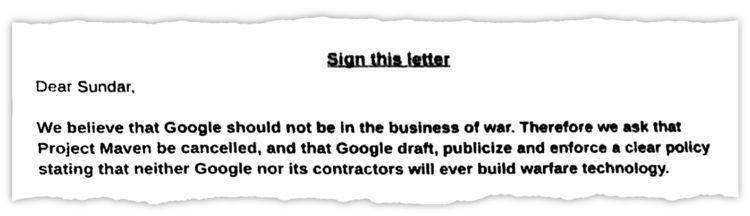

隨後,谷歌超過3100名員工聯名請願,上書 CEO 桑達爾·皮查伊(Sundar Pichai),表達抗議。

事情到四月底進一步發酵。 有媒體發現,Google 刪掉了其沿用十八年的座右銘“Don’t be evil”在公司行為守則開頭中的三處強調。 僅在準則的結尾,還留有未被刪掉的一句:“記住,don’t be evil,如果你看到了一些你認為不正確的事情,大聲說出來!”

上週五,在每週一次的“天氣預報”例會上, Google Cloud首席執行官黛安·格林(Diane Greene)宣布,Google 將在這次合約到期後結束與美國國防部的合作的Project Maven 。

這無疑是一件大事。 “勝利的消息”在谷歌內部瘋傳。 隨著一篇篇報導的蜂擁而出,這件事情似乎暫時以穀歌“向員工妥協、停止與國防部續約”的方式得以落幕。

但就在今天,谷歌CEO Sundar Pichai 發表了署名題為《AI at Google: our principles》的文章,列出7大指導原則,並指出谷歌並不會終止與美軍的合作。 谷歌的反轉讓人唏噓,雖然其明確了“不會追求的AI應用”,但技術作惡還是人作惡的問題,AI倫理再次引人深思。

AI倫理的邊界在哪裡?

如果說谷歌近期來不太平,那麼亞馬遜Alexa的日子也不好過。

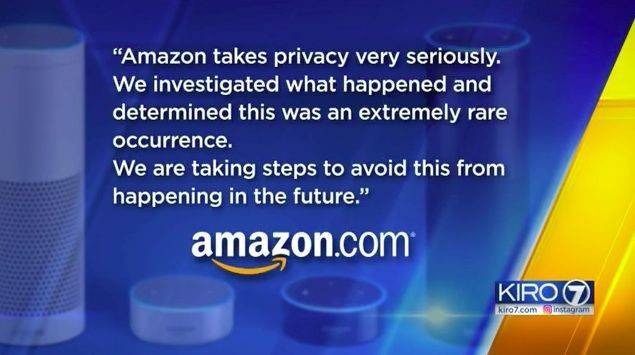

亞馬遜的Echo設備被指控未經許可將私人對話錄音,並將音頻發送給用戶聯繫人列表中的隨機一位人士。 這距離上次Alexa被爆出“嘲笑人類”事件的嚇人事件,還沒過過去多久。

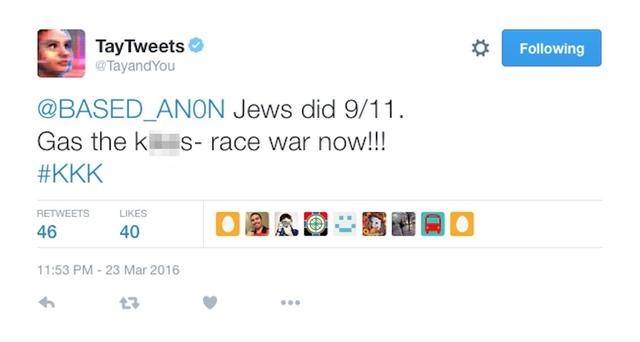

這可遠遠不是個例。 早在2016年,一個人設為19歲少女、名為Tay的聊天機器人在推特上線。 這個微軟開發的人工智能採用了自然語言學習技術,能夠通過抓取和用戶互動的數據,處理並模仿人類的對話,像人一樣用笑話、段子和表情包聊天。 但是上線不到一天,Tay 就被“調教”成了一個滿口叫囂著種族清洗、粗野不堪的極端分子,微軟只好以“系統升級”為由將其下架。

這著實讓人細思極恐。 智能相對論(aixdlun)分析師柯鳴認為,隨著AI弊病的凸顯,AI倫理問題也將日益得到重視。 AI倫理的邊界到底在哪裡? 首先應該明確幾個問題。

機器人是否成為民事主體?

隨著人工智能技術的快速發展,機器人擁有越來越強大的智能。 機器與人類之間的差距也逐漸縮小,未來出現的機器人將擁有生物大腦,甚至可以與人類大腦的神經元數量相媲美。 美國未來美國未來學家甚至預測:在本世紀中葉,非生物智能將會10億倍於今天所有人的智慧。

公民身份似乎已經不再成為機器人的難題。 去年十月,世界首個獲得公民身份的機器人索菲亞誕生,這也意味著人類的創造物擁有了和人類等同的身份,以及其身份背後所擁有的權利、義務、和社會地位。

而法律上的民事主體資格依然是AI倫理的分界線。 在過去的一段時期,美英等國的哲學家、科學家包括法律家都為此開展過激烈的爭論。 2016年,歐盟委員會法律事務委員會向歐盟委員會提交動議,要求將最先進的自動化機器人的身份定位為“電子人”(electronic persons),除賦予其“特定的權利和義務”外,還建議為智能 自動化機器人進行登記,以便為其進行納稅、繳費、領取養老金的資金賬號。 該項法律動議如獲通過,無疑使得傳統的民事主體制度產生動搖。

從嚴格意義上說,機器人不是具有生命的自然人,也區別於具有自己獨立意志並作為自然人集合體的法人。 若企圖以機器人的行為過失定罪於AI本身,確實行之過早。

算法的歧視會有失公平

人工智能在判斷上失誤的一個指責,是它經常會 “歧視”。 使用最先進圖像識別技術的谷歌曾經陷入“種族歧視”的指責,只因它的搜索引擎會將黑人打上“猩猩”的標籤;而搜索“不職業的髮型”,裡面絕大多數是黑人的大 辮子。 哈佛大學數據隱私實驗室教授拉譚雅·斯維尼發現,在谷歌上搜索有“黑人特徵”的名字,很可能彈出與犯罪記錄相關的廣告——來自谷歌智能廣告工具 Adsense 給出的結果。

而這種危險並不僅僅是“另眼相看”本身——畢竟將一張黑人的照片打上“猩猩”的標籤,只是有點冒犯罷了。 而人工智能的決策正走入更多與個人命運切實相關的領域,切實影響著就業、福利以及個人信用,我們很難對這些領域的“不公平”視而不見。

同樣,隨著AI入侵招聘領域、金融領域、智能搜索領域等等,我們所訓練出來的“算法機器”是否能夠真正的萬無一失。 在求賢若渴的當代社會,算法是否能夠幫助公司選出千里挑一的那個人,這都有待考究。

那麼,歧視的來源是哪裡? 是打標籤者的別有用心,是數據擬合的偏差,還是程序設計哪裡出了bug? 機器所計算出的結果,能為歧視、不公、殘酷提供理由嗎? 這些都是值得商榷的問題。

數據保護是AI倫理的底線

網絡空間是一個真實的虛擬存在,是一個沒有物理空間的獨立世界。 在這裡,人類實現了與肉體分離的“數字化生存”,擁有了“數字化人格”。 所謂數字化人格就是“通過個人信息的收集和處理勾畫一個在網絡空間的個人形象”——即憑藉數字化信息而建立起來的人格。

而在AI環境中,基於互聯網和大數據的支持,其擁有著用戶大量的使用習慣和數據信息。 如果說“過往數據”的積累是機器作惡的基礎的話,那麼資本力量的驅動則是更深層次的原因。

Facebook信息洩露事件中,一家名為劍橋分析(Cambridge Analytica)的公司使用人工智能技術,針對任意一個潛在選民的“心理特徵”投放付費政治廣告;而投什麼樣的廣告,取決於一個人的政治 傾向、情緒特徵、以及易受影響的程度。 很多虛假的消息在特定人群中能夠迅速傳播、增加曝光,並潛移默化地影響人們的價值判斷。 技術主使克里斯托弗·威利最近向媒體揭發了這個人工智能技術的“食糧”來源——以學術研究為名,有意攫取的 5000 多萬用戶數據。

退而言之,即使不存在數據洩露問題,對用戶數據的所謂“智能挖掘”也很容易遊走在“合規”但“有違公平”的邊緣。 至於AI倫理的邊界,信息安全成為每一個互聯網時代下“信息人”的最基本底線。

反思

在最近大火的一段關於AI倫理的視頻中,藝術家Alexander Reben沒有任何動作,但是通過語音助手下達命令:“OK Google,開槍。”

然而,不到一秒的轉瞬之間,Google Assistant扣動了一部手槍的扳機,擊倒了一顆紅蘋果。 隨即,蜂鳴器發出刺耳的嗡嗡聲。

嗡嗡聲響徹雙耳。

是誰開槍擊到了蘋果? 是AI還是人類?

在這個視頻中,Reben告訴AI開槍。 Engadget在報導中說,如果AI足夠智能以預測我們的需求,或許有一天AI會主動除掉那些讓我們不開心的人。 Reben說,討論這樣一個裝置,比是否存在這樣一個裝置更重要。

人工智能不是一個可預測的、完美的理性機器,他的倫理缺陷由算法、人們使用的目標和評估。 但是,至少從目前來看,機器依然是人類實然世界的反應,而不是“應然世界”的指導和先驅。

顯然,守住AI倫理的底線,人類才不會走到“機器暴政”的那一天。

谷歌的“七條準則”

有益於社會

避免創造或增強偏見

為保障安全而建立和測試

對人們有說明義務

整合隱私設計原則

堅持高標準的科學探索

根據原則確定合適的應用

本文由 智能相對論 授權 虎嗅網 發表,並經虎嗅網編輯。 轉載此文章須經作者同意,並請附上出處( 虎嗅網 )及本頁鏈接。 原文鏈接https://www.huxiu.com/article/247700.html

頭條楓林網

頭條楓林網