到目前為止,跟人類最像的東西應該就是AI了。 自人類誕生,從來沒有什麼能像今天的AI一樣,能如此地理解人類。

儘管它距離完全了解我們還有很遠,但已經夠好了。

深度學習讓AI再次煥發活力,其對人的模仿能力大大增強。 無論是看圖還是說話,它一直都在學著從人類的視角去看世界。 從語言學習方面來說的話,AI其實更像是鸚鵡。

也就是說,AI的一切都是從人們那裡學來的。 至少在目前來看,無論怎麼努力,它都無法越過人類日常的藩籬。 人喜歡什麼,它就喜歡什麼;人討厭什麼,它也討厭什麼。 人類會罵娘,它也能學會說法克。

從另外一個視角來看,現在人們訓練AI,幾乎就是在教一個嬰兒走路、說話、認識事物、發展智力等等。 那麼,當有一天你兒子突然罵了句娘,你意不意外?

AI語言歧視? 不過是命中之理

當年微軟推出聊天機器人Tay的時候,滿以為會打開一扇新世界的大門,沒想到大門是打開了,裡面卻不是新世界。 短短不到24個小時,Tay已經學會了說髒話和發錶帶有種族歧視、反動色彩的言論。 沒辦法,微軟只好讓它緊急閉嘴。

而這也僅僅只是個開始而已。 隨後智能音箱相繼邁入市場,背負著聊天對話、家居入口的使命,最後仍然逃不掉罵人的命運。 隨口來個國罵“法克尤”什麼的,根本都不是個事兒。

不僅僅是“出言不遜”,AI也開始逐步學會用人的眼光“打量”這個世界。 去年就有人曝出谷歌翻譯將護士翻譯為“she”,而將醫生翻譯為“he”,由此而引發了關於AI職業歧視的問題;將黑人和大猩猩識別為同一種生物,又引發了 AI的種族歧視……

從人們發現這個問題開始,關於由語言歧視引發的AI道德論的紛爭就沒有停止過。 一方面畢竟AI的黑箱還沒有打開,有些人認為這就是AI的主觀故意行為;另一方面,畢竟媒體們得寫點兒什麼來賺取閱讀量,所以給機器人加上一些人類都敏感的名詞 ,自然也符合看熱鬧群眾的獵奇心理。

但嚴肅來講,AI的語言歧視問題完全沒有必要上升到全民批判甚至精神緊張的高度, 一旦從技術的層面去分析問題,就會發現,這原本就是個命中之理。

那這個理是什麼?

禍是惹了,但鍋背不了

首先我們弄清楚,智能音箱為什麼會罵人?

這和它的工作程序是密切相關的。 我們知道智能音箱主要有兩個作用,一個是陪人聊天,另一個是家居控制。 在目前家居控制得還不太順利場景下,聊天已經成為了智能音箱的最主要作用。 那,聊天聊什麼?

我國人民最喜歡逗小孩兒,每次都以把小孩兒逗哭為最大的樂子。 那有了智能音箱,就又多了個逗的玩具。 人就是這樣,在單位跟人說正經話太累,回到家裡就想說點兒不正經的。 作為一種新生事物,智能音箱是除了孩子之外第一個能學舌的物件了。 所以,你好啊、唱歌啊之類的日常對話膩歪了,大家就像逗逗它:對它說兩句髒話怎麼樣?

有了第一句,就有了第二句。 國罵教完了,開始花式罵架。 以智能音箱的學習能力,掌握這點兒東西自然不在話下。

其實學幾句髒話不難,畢竟這是AI的看家本領。 但我們必須要時刻清楚點的一件事是: 你認為AI罵人了,但AI自己並不知道。

也就是說,它根本沒有詞的情感色彩點的概念。 在這一點上,它和兩三歲的幼兒是一樣的。

同樣的原理,對種族甚至是職業方面的歧視現像也是必然會發生的。 對職業而言,比如上文提到的護士和醫生,相關數據確實表明,在全球女性在護士總體中占到了90%,而在中國更是高達98%以上。 與之相比美國醫學院校男性職工則占到六成以上,並且隨著職稱的提高這個比例還會上升。

同樣,美國卡耐基基梅隆的調查人員也發現,在谷歌搜索當中,如果瀏覽器認為你是個男性,會給你推荐一些薪水更高的職業。 並且在一些算法中,黑人名字往往和消極性詞彙聯繫在一起,而白人名字則和往往積極向上的詞眼在一塊兒。

如同AI沒有詞的情感色彩觀念,它當然也就沒有種族和職業觀念。 其在進行數據學習的時候會採用大概率的內容來給某一類用戶進行畫像,然後才會輸出類似的價值觀。 事實上,黑人在美國的犯罪率確實要高一點,而女子的薪資水平也大概只有男子的81%左右。

從以上的分析我們可以得出一個基本的結論: AI無意對任何人、任何職業進行言語歧視,它所表現出來的一切,全都都是基於客觀數據而生成的用戶畫像。

但是,無意代表無罪嗎? 雖然沒有主觀上的意願,但它至少造成了客觀上歧視的事實。 人們做出來AI,不是讓它給我們帶來有意或無意的傷害的。 被人冷嘲熱諷也就算了,活得連機器都看不起,那人豈不是要跳樓?

所以,這口鍋到底該由誰來背?

懂得越少,就越容易說錯話

AI的三大生命支撐裡,數據、算力和算法三者缺一不可,但同時又擔負AI生長的不同任務。 相較之下,算力為AI的大面積擴張提供了可能,而數據和算法則直接影響了它的生命走向:成為一個寵兒,亦或是全民公敵。

那麼,對詞彙情緒識別錯誤、職業種族的強加,前者缺乏了對情緒的識別,後者則將不完全歸納奉為圭臬。

事實上,已經有許多公司和科研機構展開了對AI的情緒識別的研究。

國內的如阿里巴巴和清華大學合作成立的自然交互體驗實驗室,其就將研究領域定位在情感認知計算、實體交互、多通道感知等領域,讓機器具備聽覺、視覺、觸覺等五感,從而 理解人類的情感。 AI之所以罵人,值得關注的一點就是其將語言僅僅視作一種指向,而不對這種指向進行背後的含義分析。

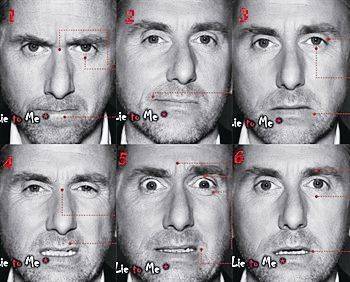

如果加入了對對話者表情、對話場景、對話對像等的綜合分析,這種語言的指向性對機器而言將更豐富,其避免出口成臟的可能性也就更大。

而在最近,一家位於倫敦的初創公司Realeyes則推出了一款AI攝像頭,它利用計算機視覺來讀取一個人在觀看長達6秒鐘的視頻時的情緒反應,然後利用預測性分析來幫助將 這些反應映射到視頻中,以提供關於視頻效果的反饋。

也就是說,識別情緒必須要帶點兒圖。

這樣的邏輯看上去沒有什麼問題,但實施起來困難重重。 而要解決這些困難,或許構建完備的知識圖譜是一個不錯的選擇。

仍以AI罵人來分析。 我們可以看看,在避免AI罵人的背後有多少的內容需要其消化吸收。

首先,AI要知道哪些詞彙是用來罵人的。 可不要以為這是一個簡單的東西,首先詞彙量就夠大,古人有文縐縐的“豎子”,今人有張口就來的“傻X”。 人民群眾吃飽飯沒事兒乾什麼? 打屁唄。 打了幾千年,髒話在各地的方言中五花八門,要消化就得一陣子。

其次,在不同的使用場景下,詞語是會褒貶轉化的。 比如女生對男生撒嬌“你真是個壞蛋”,AI忽略了這個場景,然後抓住“壞蛋”,還以為女生受到了威脅,然後順手報了個警怎麼辦? Echo報警這事兒也早都不是新聞了。

最後,也是最難的,AI如何識別出一套髒話的邏輯? 罵人不帶髒字的人大有人在。 就算AI掌握了所有的髒話詞彙,並將其成功過濾掉,但是仍然可能會對一些深藏不露的話術選擇學習吸收,最後難免也會出現問題。

也就是說,一張“詞彙+場景+邏輯”的髒話知識圖譜的構建是AI能夠在交流中避過語言問題的基礎。 但除此之外就萬事大吉了嗎?

當然不是。

知識圖譜不應該僅僅只有語言

人與人的交流如果只是吐出來幾個單詞,那未免也太簡單了,簡單得就像個1。 除了語言之外,還包括動作、表情、聲調等等。 所以說,要解決髒話問題,這張知識圖譜的內容還應該包含更多。

人機交流要想更加自然、更加和諧,還需要去進行人說話時的常用姿勢含義、表情尤其是微表情以及說話音調的高地等方面的知識圖譜的構建。 值得注意的是,這些知識圖譜也並不是簡單的構建和疊加。 要知道,語言、動作、表情和聲調之間可以做海量的排列組合,不同的組合之間又代表著不同的情緒。

而目前這項工作幾乎是一片空白。 雖然有不少的機構都在研究表情、肢體等具體動作的含義,但基本上僅限於個別表情的表面含義,但這一層並不是知識圖譜的全部內容。 從表層含義到背後情緒到語言相關到動作相關,這一系列複雜的內容都是需要投入精力來完成的。

那麼,假如知識圖譜構建完畢,下一個難題可能就要交給算法了。 如何把如此巨大的信息進行捏合,並判斷得準確,工程量不容小覷。

如果這一切都能完成,那麼,AI將可能不再會僅僅因為膚色和那些片面的數據來去判斷一個人的品質,也將不自作主張地將所有的職業都分配給指定的性別。 它在罵人的時候會三思而緘口,在更廣闊的識別判斷上也將做出更為公正、更為客觀的決定。

而正如上文我們提到的,AI所謂的“歧視”表現,正是對現實情況的一個讀取。 所以在某種程度上,人類把AI的歧視放大了。 要從根本上改變這種現象,最應該反思的其實是人類自己。 那麼,從這個角度上來講,AI的歧視反而是一件好事,它讓人類從第三者的角度重新認識了自己,並發現一些潛移默化而自身渾然不覺的問題。 利用對AI的這種意外“收穫”來反省人類自身,對消除人類社會的偏見也有助力。

誠然,讓AI讀懂人類將是一個遙遠而艱辛的路程。 時至今日,AI更像是一個幼兒,它全盤接受著來自這個世界的所有內容,而後年歲漸長,更懂得世界的善惡、冷暖、喜怒和哀樂。 而我們要做的,就是不斷拍去它成長路上沾染的灰塵,令其成為一個乾淨的人工智能。

本文由 腦極體 授權 虎嗅網 發表,並經虎嗅網編輯。 轉載此文請於文首標明作者姓名,保持文章完整性(包括虎嗅注及其餘作者身份信息),並請附上出處(虎嗅網)及本頁鏈接。 原文鏈接:http://www.huxiu.com/article/245796.html

未按照規範轉載者,虎嗅保留追究相應責任的權利

頭條楓林網

頭條楓林網