AI機器人競選市長了!

沒錯,這種存在於科幻小說中的劇情如今照進了現實生活中。 近日,日本一個機器人提名為多摩市市長候選人,承諾將對所有市民一視同仁,不偏不倚,競選口號為“為每個人提供公平、均等的機會”。

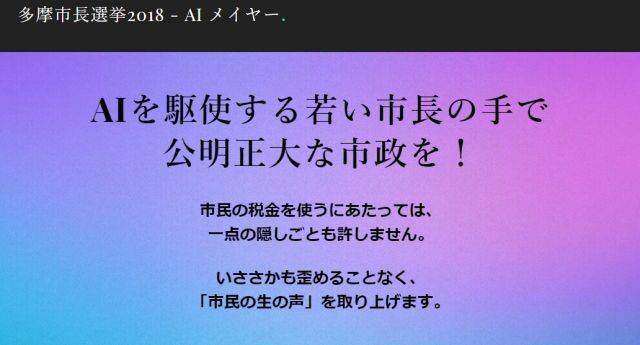

起初人們以為這僅是競選者的cosplay,而後來發現,這是一個如假包換的機器人,其後AI候選人開通了自己的官方推特宣傳賬號,還給出了自己競選的政見:讓 政治變得更加公平。

其後,機器人還列舉出了自己的幾大競選優勢:其一,機器人沒有情緒也沒有慾望,在處理政務時,既不會夾帶私人感情也能防止腐敗;其二,機器人不用休息,可以長 時間高強度工作;其三,相對人類隨著年齡增長的記憶力退化,機器人可以始終保持大量信息存儲……

無獨有偶,此前的一位來自新西蘭的機器人公務員“薩姆”也賺足了眼球,“薩姆”能夠回答市民提出的有關住房、教育和移民的問題,而且其自己曾“表示”,在做決定 時將會考慮每個人的立場。

事實真的如此嗎? 機器人當市長這件事兒靠譜嗎? 智能相對論(ID:aixdlun)分析師柯鳴認為,想要機器人真正勝任市長一職,甚至讓機器人大範圍的替代傳統公務員,不得不思考這幾個問題。

機器人能否成為道德主體?

既然要辦事,那麼就要為自己可能出現的錯誤承擔責任。 但機器人是否能夠獨立承擔自身責任成為道德主體呢? 我們先來看看著名的約翰·希爾勒(John Searle)“中文房間”實驗:

想像一位只說英語的人身處一個房間之中,在封閉的房間中其只攜帶一本寫有中文翻譯程序的書。 寫著中文的紙片通過小窗口被送入房間中。 根據Searle,房間中的人可以使用他的書來翻譯這些文字並用中文回复。 雖然他完全不會中文,Searle認為通過這個過程,房間裡的人可以讓任何房間外的人以為他會說流利的中文。

當然,“中文房間”實驗也引起了起了人們對於人工智能的一些爭論。 但在這場爭論中,人們並沒有排除人工智能體自主道德設計的可能性,而實際上人工智能體的設計與智能體作為道德主體的建立還是有區別的。 關於意識、理解力等概念的認識與如何才能使機器人的行為符合道德規範的實際議題基本上是不相干的。

那麼,我們再來看看人類道德在機器人領域是否有一定的適用性。 道德規範在我們的日常生活中普遍存在,也存在於有組織的社會活動中,在馬克思看來,道德是對特定經濟基礎反應的上層建築。

但由於人工智能科學日新月異,以及自主機器人廣泛的存在與應用,自主機器人早已參與了我們繽紛多彩世界中的生活,世界不論怎樣都已不得不討論自主機器人的道德地位了。

溫德爾·瓦拉赫與科林·艾倫教授合著的《道德機器:如何讓機器人明辨是非》一書中對於機器人是否應當或者能夠擔負起道德責任、人工道德智能體(AMAs)提出了解決方案 :一種是自上而下式的理論進路,是指通過將機器人所要掌握的知識與能力轉化為一系列算法規則,把這些規則植入機器人的“大腦”,從而獲得“認知”; 另一種是自下而上式的發展進路則是通過模擬孩童的成長過程,讓機器人在不同環境的相互作用中習得複雜行為與認知的能力與知識。

從目前服務類(如公務員)機器人的表現來看,其深度學習、高度自動化等依然是其固有痼疾的基礎上,談論機器人自身的道德主體性也許行之過早了。

機器人公務員真的能夠毫無偏見嗎?

從日本AI機器人競選市長到新西蘭機器人“薩姆”,無一不是宣揚其具有公正性、無任何私情。 然而,在還未到達“超人工智能”的當下,機器人難以形成自身思想之前,算法的偏見,似乎一直都是難以克服並為人詬病之處。

所謂的“算法偏見”是指在看似沒有惡意的程序設計中,卻不自覺的帶有設計人員或開發者的偏見,或者中擬定程序的過程中,採用的數據是具有一定偏見性的。 這種情況帶來的後果是巨大的,例如,Google搜尋被曲解、合格的考生無法進入醫學院就學、聊天機器人在推特(Twitter)上散佈種族主義和性別歧視信息等。

算法偏見造成最棘手的問題之一是,從事程序設計的工程師,即便本身沒有種族、性別、年齡歧視等傾向,也有可能造成偏見。 AI本質上就是為了自行學習而設計,有時它的確會出錯。

在AI招聘領域,一個最為典型的案例就是頂級管弦樂隊選角,古典音樂過去一直以男性為主,但在20世紀70年代引入了盲目的試鏡,這使頂級樂團的女音樂家增加了五倍 以上。

但是,這並沒有解決根本性的問題,第一批通過盲目試鏡入選的女性依然無法融入日常演奏,樂隊不得不尋找其他男性演奏家。

而我們的AI招聘:就像管弦樂隊的幕布一樣,機器學習是一種範式轉變,有可能消除長期存在的偏見,但它本身並不能解決幾個世紀的偏見。

回到機器人公務員領域,其工作內容中也不乏“價值判斷”的部分,如材料完整度如何可以報賬? 組織部評價評優又是以何為尺度? 而作為市長的日常事務的裁斷更是需要一定的標準。 而目前的機器人深度學習能夠實現的就是“算法裁決”,這又再次落入了算法偏見的窠臼之中。

服務類公務員機器人,你敢安心讓它上崗嗎?

事實上,大眾並不敢讓機器人完全代替公務員工作,包括市長。

AI市長在日本的競選中敗了,而且很徹底。 截止至最後日本多摩市的公投結果顯示,“AI市長”僅獲4013票,較現任多摩市長阿部裕行獲得的34603票相距甚遠。

《人工智能》里大衛和媽媽的一段對話讓人印象深刻。 當大衛詢問媽媽晚飯吃什麼時,媽媽告訴它,機器人是不能吃飯的。 大衛卻說:“我知道,但是我喜歡和家人一起坐在餐桌上。”正如劇中男主角所說,大衛既然懂得愛,那他也應該懂得恨。 當人工智能愈發先進、愈發智能時,人類會不會被科學這把利刃劃破雙手?

正如當下機器人動手術、機器人管理金融等領域,許多人對此依然無法完全信任。 機器人終究是少了一點“人氣”,在公務員領域,沒有了面對面的噓寒問暖,只是例行公事地辦證取證,工作似乎也少了許多樂趣。

此外,機器人公務員的應用範圍也是相當狹窄的。 從目前來看,隨著世界數據化程度不斷加深,與個人相關的數字類信息可由機器人逐步替代,如社保處理、出國簽證、納稅等;另一類型的公務員機器人則與富士康工場裡機器人替代傳統 的工人類似,通過生物識別確認人員身份等類型的工作均可由機器人充當。

但是,AI也未達到完美的程度。 比如許多開發者經常會把他們的偏見寫入人工智能項目,最近一項研究也發現,AI的語言翻譯工具已經具有種族主義和性別歧視的偏見。

阿西莫夫在《我,機器人》一書中曾提出機器人三定律:

第一定律:機器人不得傷害人類個體,或者目睹人類個體將遭受危險而袖手不管;第二定律:機器人必須服從人給予它的命令,當該命令與第一定律衝突時例外;第三定律: 機器人在不違反第一、第二定律的情況下要盡可能保護自己的生存。

顯然,目前機器人仍然遵循著這基本的要求,但隨著機器人技術的日益發展,會有更多類型的機器人出現,當真正機器人與人類倫理髮生衝突時,如何協調人工智能與人類的關係也將 成為當今時代下必須重視的課題。

當然,也希望霍金的預言永遠也不會成為現實。

本文由 智能相對論 授權 虎嗅網 發表,並經虎嗅網編輯。 轉載此文章須經作者同意,並請附上出處( 虎嗅網 )及本頁鏈接。 原文鏈接https://www.huxiu.com/article/242230.html

頭條楓林網

頭條楓林網