波士頓動力的網紅機器狗不僅能穩步行走,還能送快遞,但是科學家們對狗和AI的暢想遠不止於此。

他們想知道,AI從一隻汪星人的身上可以學到什麼?

華盛頓大學與艾倫人工智能研究所的答案是,記錄一隻汪星人在各種環境中行走、取物,在狗公園玩耍、吃東西的數據,將狗的動作和到所看到的東西同步 ,然後形成一個“汪星人”行為數據集,並用它來培訓新的AI模擬器。

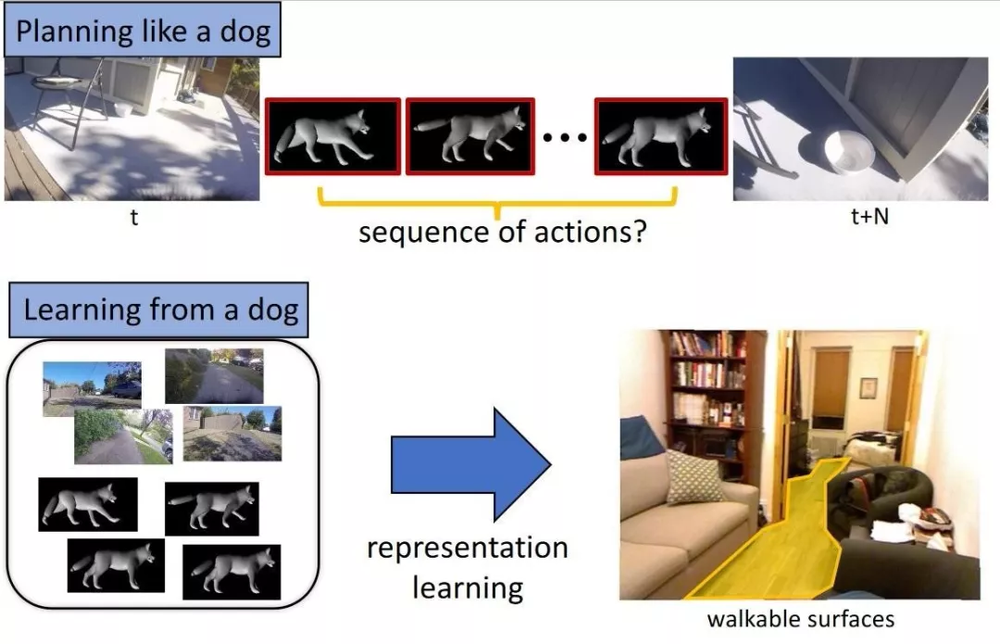

這個“汪星人”AI在給出某種感官上的輸入後,比如說說一個房間或街道的景象,或者一個飛過它的球——會預測一隻狗在這種情況下會做什麼。

簡單來說就是, 學習成為一隻優秀的汪星人。

訓練機器學習系統來識別物體、從而進行街道導航及面部表情識別這樣的任務雖然艱難,但它們卻根本比不上進行模擬(如模擬狗的行為)的複雜程度。

華盛頓大學與艾倫人工智能研究所之間的這一合作成果,論文將在6月份在CVPR上發表(譯者註:CVPR-IEEE Conference on Computer Vision and Pattern Recognition的縮寫,即IEEE國際計算機視覺與 模式識別會議)。

通過這個項目,研究者試圖讓AI通過觀察一隻溫順的狗,來基礎性地了解,怎樣像狗一樣行事。

為什麼要進行此項工程呢?

研究者稱,我們已經做了很多模擬感知的子任務,比如識別一個對象並提取它,但是在“理解智能代理人的動作與行為數據並在虛擬世界中呈現”方面卻做的還遠不夠。

換句話說,我們需要模擬行動,不只是做一隻眼睛,而是成為控制眼睛的樞紐。

那麼為什麼選擇狗呢?

汪星人是具有足夠複雜性的智能生物,“他們的目標和動機往往是先驗未知的。”換句話說,狗很聰明,但我們不知道他們在想什麼。

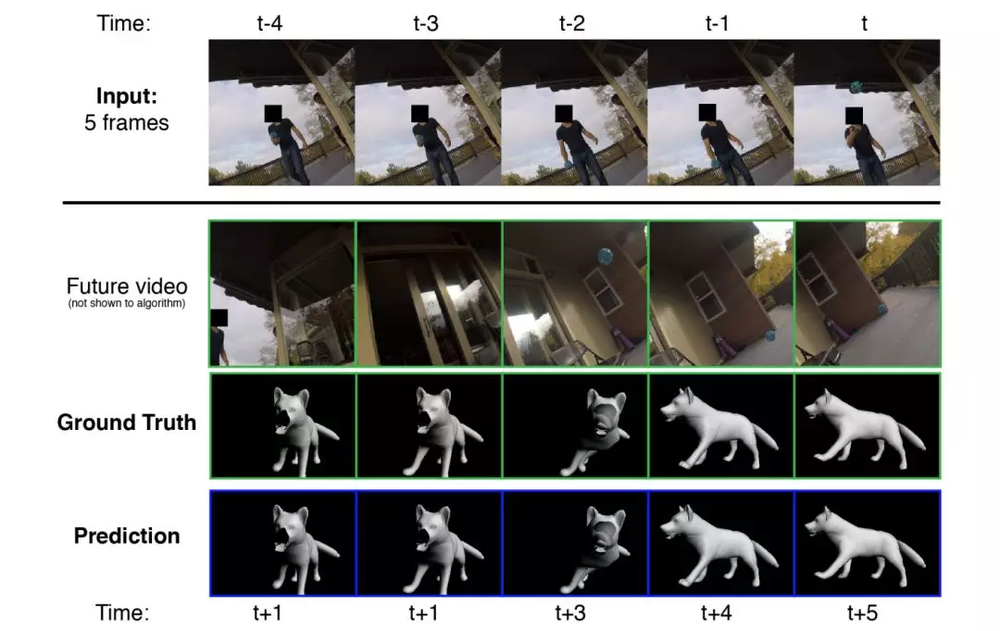

作為對這一研究項目的初步嘗試,該團隊希望通過密切監測狗並將其動作、行為和它所看到的環境相結合,來觀察他們是否能夠創建一個準確預測這些動作的系統。

為了做到這一點,他們給一隻叫Kelp的愛斯基摩犬裝上了基本的傳感器。 在Kelp的頭上有一個GoPro攝像頭,六個慣性測量單元(腿,尾巴和軀幹),可以判斷所有物體的位置,一個麥克風和一個Arduino(開源硬件)將數據綁定在一起。

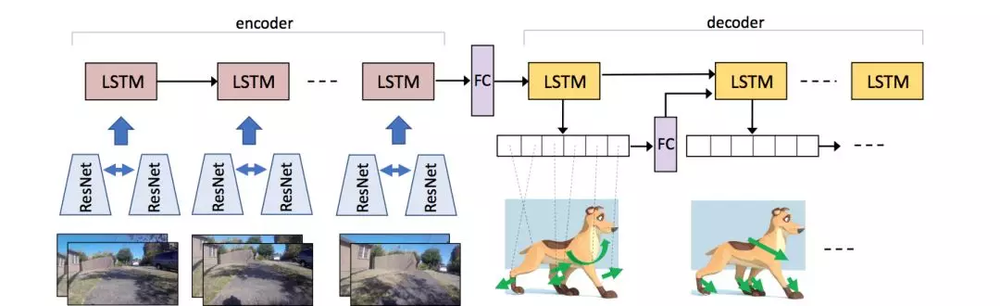

他們記錄了Kelp數小時的活動——觀察狗在各種環境中行走,取物,在狗公園玩耍,吃東西,將狗的動作同步到所看到的東西。 其結果是狗環境中以自我為中心行動的數據集,或“DECADE”(他們用它來培訓新的AI代理)。

這位代理在給出某種感官上的輸入後——比如說說一個房間或街道的景象,或者一個飛過它的球——會預測一隻狗在這種情況下會做什麼。 當然,這樣的預測不會嚴肅到細節水平——但即使只是想出如何移動它的身體以及在哪裡完成也是一項非常重要的任務。

研究人員中的Hessam Bagherinezhad在一封電子郵件中解釋道:“它學習瞭如何移動關節走路、如何在走路或跑步時避開障礙物、追逐松鼠、追隨主人,在玩耍時追踪飛行的玩具等等 。

這些是計算機視覺和機器人技術中的一些基本的AI任務,我們一直試圖通過為每個任務收集單獨的數據來解決這些問題(例如,運動規劃,步行表面,物體檢測,對象跟踪,人員識別)。 ”

這可以產生一些相當複雜的數據:例如,狗模型必須像狗本身一樣知道,當它需要從這裡到達那裡時哪裡可以行走。 它不能在樹、汽車或沙發(依據房間信息)上行走。

通過模型也可以了解到,這項研究可以作為計算機視覺模型單獨部署,以找出寵物(或小腿機器人)在給定場景中可以達到的位置。

研究人員說,這只是一個初步實驗,雖然取得了成功,但成果有限。 其他人可能會考慮引入更多的感官(嗅覺數據是很有必要的)數據,或者看看一隻(或許多)狗產生的模型如何推廣到更大範圍。

他們總結道:“我們希望通過這項工作,為我們更好地理解視覺智能和其他智能生物鋪平道路。”

參考資料:

本文由 大數據文摘 授權 虎嗅網 發表,並經虎嗅網編輯。 轉載此文請於文首標明作者姓名,保持文章完整性(包括虎嗅注及其餘作者身份信息),並請附上出處(虎嗅網)及本頁鏈接。 原文鏈接:http://www.huxiu.com/article/242169.html

未按照規範轉載者,虎嗅保留追究相應責任的權利

頭條楓林網

頭條楓林網