概要:關於人工智能,長期存在兩種不同的目標或者理念。

關於人工智能,長期存在兩種不同的目標或者理念。 一種是希望藉鑑人類的智能行為,研製出更好的工具以減輕人類智力勞動,一般稱為“弱人工智能”,類似於“高級仿生學”。 另一種是希望研製出達到甚至超越人類智慧水平的人造物,具有心智和意識、能根據自己的意圖開展行動,一般稱為“強人工智能”,實則可謂“人造智能”。

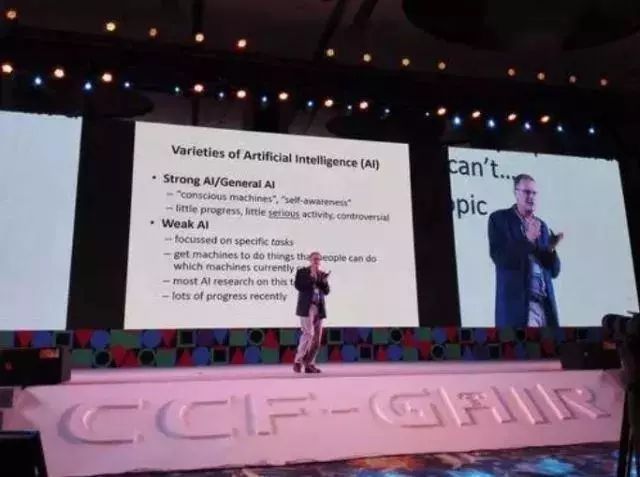

人工智能技術現在所取得的進展和成功,是緣於“弱人工智能”而不是“強人工智能”的研究。 正如國際人工智能聯合會前主席、牛津大學計算機系主任邁克爾·伍德里奇(Michael Wooldrige)教授在2016年CCF-GAIR大會¹報告中所說:強人工智能“幾乎沒有進展”,甚至“幾乎沒有 嚴肅的活動”(“little progress, little serious activity”)。 事實上,人工智能國際主流學界所持的目標是弱人工智能,也少有人致力於強人工智能。

►牛津大學邁克爾·伍德里奇教授

首先,從技術上來說,主流人工智能學界的努力從來就不是朝向強人工智能,現有技術的發展也不會自動地使強人工智能成為可能。

不妨看看現在人工智能技術所取得的成功。 在圖像識別、語音識別方面,機器已經達到甚至超過了普通人類的水平;在機器翻譯方面,便攜的實時翻譯器已成為現實;在自動推理方面,機器很早就能進行定理自動證明;在棋 類游戲方面,機器已經打敗了最頂尖的人類棋手……可以看出,上述成功有一個共同的特點:它們都是在考慮某種特定類型的智能行為,而不是“完全智能”行為²。 一方面,聚焦在特定類型的智能行為上,才使得任務成為可能而非空談³;另一方面,如果目標是製造“工具”,那麼考慮特定類型的智能行為就已足夠,自主心智、獨立意識 、甚至情感⁴之類的東西,根本無須考慮。 打個未必恰當的比方,如果人們的目標是造個工具砸東西,那麼造出錘子來就好了,無須考慮讓錘子有心智、意識,也不必考慮是否要讓錘子自己感覺到“疼”。 事實上,人工智能研究活躍的子領域,都是與製造智能“工具”直接相關的;而對“強人工智能”必不可少、卻與“工具”不太相關的內容,如自主心智、獨立 意識、機器情感之類,罕有嚴肅的研究。 所以,現有技術即便發展再快、發展再好,也不會直接使得強人工智能成為可能。

第二,即便想研究強人工智能,也不知道路在何方。

有一種說法,認為如果能夠模擬出“人腦”,把其中的神經元、神經突觸等全部同規模地仿製出來,那麼強人工智能就會自然產生。 然而,這種說法從來沒有得到過一點點證明,嚴格說來甚至不能稱其為“猜想”,因為猜想也應該有一些即便不夠完備但尚能顯示可能性的證據,例如通過仿製簡單細胞,做 出了單細胞智能生物。 實際上,我們完全有更強烈的理由認為,即便能精確地觀察和仿製出神經細胞的行為,也無法還原產生出智能行為。 正如國際人工智能終身成就獎得主、多倫多大學赫克托·萊韋斯克(Hector J. Levesque)教授在他2017年的新著⁵中所說,即便在最理想的情況下,神經科學家也僅是 能獲得“目標代碼”而已,沒有理由認為獲得了目標代碼就能還原出源代碼,因為這樣的“反向工程”即便對軟件程序來說也幾乎是不可能的,更何況神經細胞內部還存在 “分佈式表示”⁶。

第三,即便強人工智能是可能的,也不應該去研究它。

任何一個科學研究領域或許都存在一些不該去觸碰的東西。 例如克隆人是被主流生命科學界所禁止的。 強人工智能的造物將具有自主心智、獨立意識,那麼,它憑什麼能“甘心”為人類服務、被人類“奴役”? 有人把阿西莫夫的“機器人三定律”⁷奉為圭臬,但事實上這是行不通的。 且不論三定律自身的矛盾和漏洞⁸,憑什麼以為有自主心智和獨立意識,且智能全面達到甚至超越人類水平的機器,就不會把這些約束改掉呢? 即便它是善意的,人類又憑什麼認為它會同意比它“愚蠢”的人類的判斷? 例如它會不會以為把人類全部關進監獄就可以避免人類互相殘殺,這才是對人類整體最好的? 至於說,到時候人類如果覺得危險了,可以把機器的電源斷開……這只是開個玩笑吧,真到那個時候,機器恐怕早就能採用其他的方式攝入能源了。 總之,強人工智能出現的那一天,恐怕真的就是人類面臨最大生存危機的時候。 所以,對嚴肅的人工智能研究者來說,如果真的相信自己的努力會產生結果,那就不該去觸碰強人工智能。

頭條楓林網

頭條楓林網